Ces dernières années, le monde de la téléphonie mobile a connu d’énormes changements. Nous pouvons constater des différences fondamentales dans pratiquement tous les aspects, que nous nous concentrions sur la taille, le design, les performances ou d'autres fonctions intelligentes. La qualité des caméras joue actuellement un rôle relativement important. Pour le moment, on pourrait dire que c'est l'un des aspects les plus importants des smartphones, dans lequel les produits phares sont constamment en concurrence. De plus, lorsque l'on compare, par exemple, les téléphones Android avec l'iPhone d'Apple, on constate un certain nombre de différences intéressantes.

Il pourrait être vous intéresse

Si le monde de la technologie mobile vous intéresse, vous savez sûrement que l’une des plus grandes différences se situe dans le cas de la résolution du capteur. Alors que les androïdes proposent souvent un objectif de plus de 50 Mpx, l'iPhone mise depuis des années sur seulement 12 Mpx, et peut encore proposer des photos de meilleure qualité. Cependant, peu d’attention est portée aux systèmes de focalisation d’image, où l’on rencontre une différence assez intéressante. Les téléphones concurrents équipés du système d'exploitation Android s'appuient souvent (partiellement) sur ce que l'on appelle la mise au point automatique laser, tandis que les smartphones portant le logo pomme mordu ne disposent pas de cette technologie. Comment cela fonctionne-t-il réellement, pourquoi est-il utilisé et sur quelles technologies Apple s'appuie-t-il ?

Mise au point laser contre iPhone

La technologie de focalisation laser mentionnée fonctionne assez simplement et son utilisation est très judicieuse. Dans ce cas, une diode est cachée dans le module photo, qui émet un rayonnement lorsque la gâchette est enfoncée. Dans ce cas, un faisceau est envoyé, qui rebondit sur le sujet/objet photographié et revient, ce temps pouvant être utilisé pour calculer rapidement la distance grâce à des algorithmes logiciels. Malheureusement, il a aussi son côté sombre. Lorsque vous prenez des photos à de plus grandes distances, la mise au point laser n'est plus aussi précise, ou lorsque vous prenez des photos d'objets transparents et d'obstacles défavorables qui ne peuvent pas refléter le faisceau de manière fiable. Pour cette raison, la plupart des téléphones s'appuient toujours sur l'algorithme éprouvé pour détecter le contraste de la scène. Un capteur doté d’un tel capteur peut trouver l’image parfaite. La combinaison fonctionne très bien et garantit une mise au point rapide et précise de l’image. Par exemple, le populaire Google Pixel 6 dispose de ce système (LDAF).

D’un autre côté, nous avons l’iPhone, qui fonctionne un peu différemment. Mais au fond, c’est assez similaire. Lorsque la gâchette est enfoncée, le composant ISP ou Image Signal Processor, qui a été considérablement amélioré ces dernières années, joue un rôle clé. Cette puce peut utiliser la méthode de contraste et des algorithmes sophistiqués pour évaluer instantanément la meilleure mise au point et prendre une photo de haute qualité. Bien entendu, sur la base des données obtenues, il est nécessaire de déplacer mécaniquement l'objectif dans la position souhaitée, mais tous les appareils photo des téléphones portables fonctionnent de la même manière. Bien qu’ils soient commandés par un « moteur », leur mouvement n’est pas rotatif, mais linéaire.

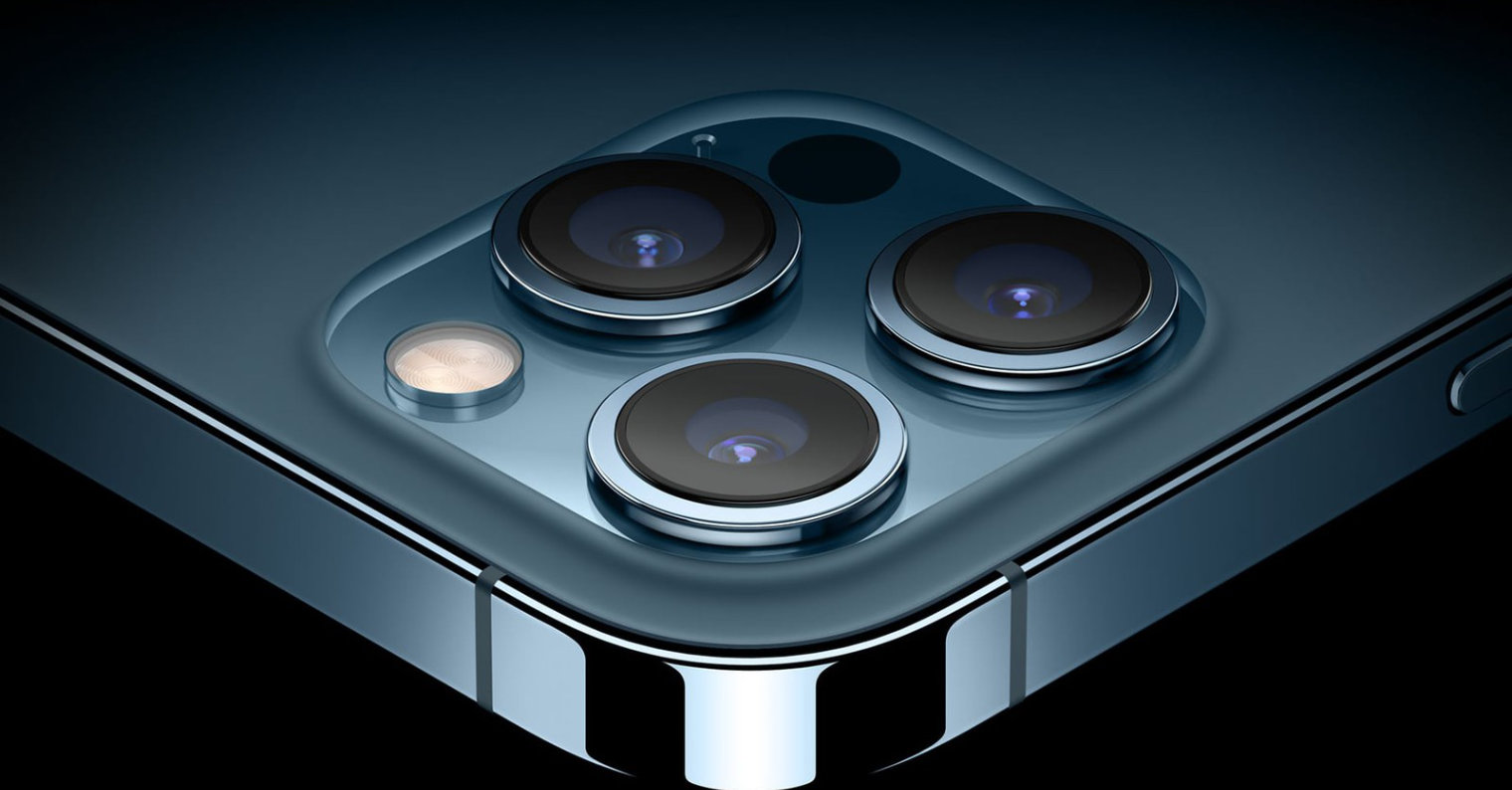

Les modèles iPhone 12 Pro (Max) et iPhone 13 Pro (Max) ont une longueur d'avance. Comme vous l'avez peut-être deviné, ces modèles sont équipés d'un scanner dit LiDAR, qui peut déterminer instantanément la distance par rapport au sujet photographié et utiliser ces connaissances à son avantage. En fait, cette technologie est proche du foyer laser mentionné. Le LiDAR peut utiliser des faisceaux laser pour créer un modèle 3D de son environnement, c'est pourquoi il est principalement utilisé pour scanner des pièces, dans des véhicules autonomes et pour prendre des photos, principalement des portraits.

Il pourrait être vous intéresse

Adam Kos

Adam Kos

Voler autour du monde avec Apple

Voler autour du monde avec Apple