Apple ne pouvait pas attendre. Même s'il a prévu sa keynote d'ouverture de la WWDC début juin, le domaine de l'IA progresse chaque jour, ce qui explique probablement pourquoi il ne voulait pas perdre plus de temps. Sous forme de communiqué, il a exposé ce que son intelligence artificielle sera capable de faire dans iOS 17 et y a ajouté d'autres fonctions qui tournent autour de l'accessibilité. Il y en a beaucoup, les fonctions sont intéressantes, mais il y a un point d'interrogation sur l'utilisabilité de masse.

Il pourrait être vous intéresse

L'annonce de la nouvelle a également été soutenue par la Journée mondiale de l'accessibilité, qui a lieu jeudi, car les fonctionnalités nouvellement introduites tournent autour de l'accessibilité des iPhones de A à Z. L'accessibilité est un grand bloc de fonctionnalités sur l'iPhone qui est destiné à aider à le contrôler partout. différentes formes de handicap, même si beaucoup d'entre elles bien sûr, tout le monde peut les utiliser, ce qui s'applique également aux nouveautés que nous verrons dans iOS 17. Cependant, toutes, comme Assistive Access, ne sont pas toutes basées à 100 % sur l'IA.

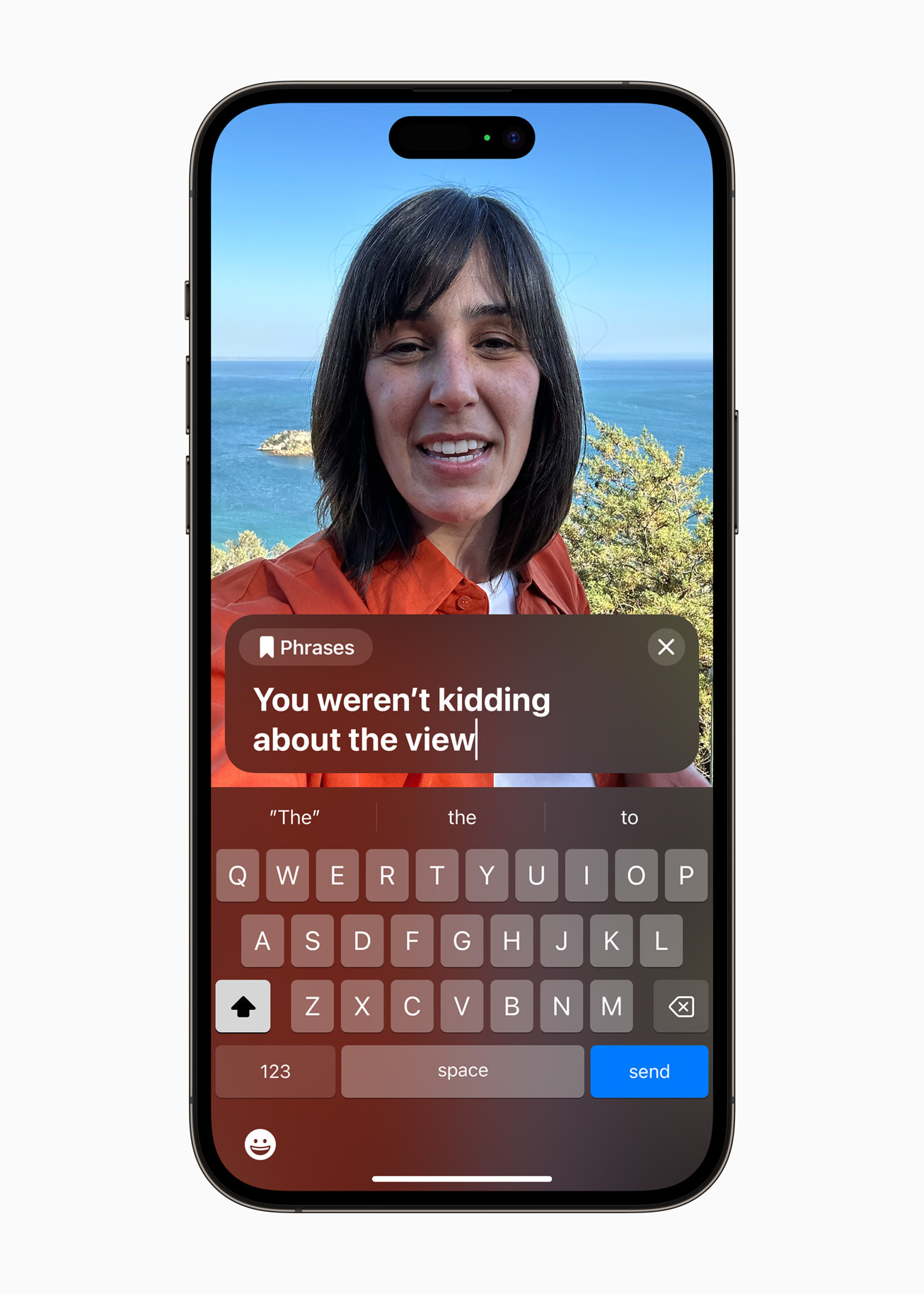

Discours en direct

Ce que vous écrivez sur l’écran de l’iPhone sera lu de l’autre côté. Cela devrait fonctionner localement, mais cela devrait également fonctionner lors d'un appel téléphonique. La fonction pourra fonctionner en temps réel, mais en même temps elle proposera des phrases prédéfinies pour rendre la communication non seulement la plus simple, mais aussi la plus rapide, lorsqu'il ne sera pas nécessaire d'écrire les connexions fréquemment utilisées. Il y a une grande question de disponibilité, c'est-à-dire si cela fonctionnera également en langue tchèque. Nous l’espérons, mais nous n’y croyons pas trop. Ce qui, après tout, s’applique également à d’autres actualités.

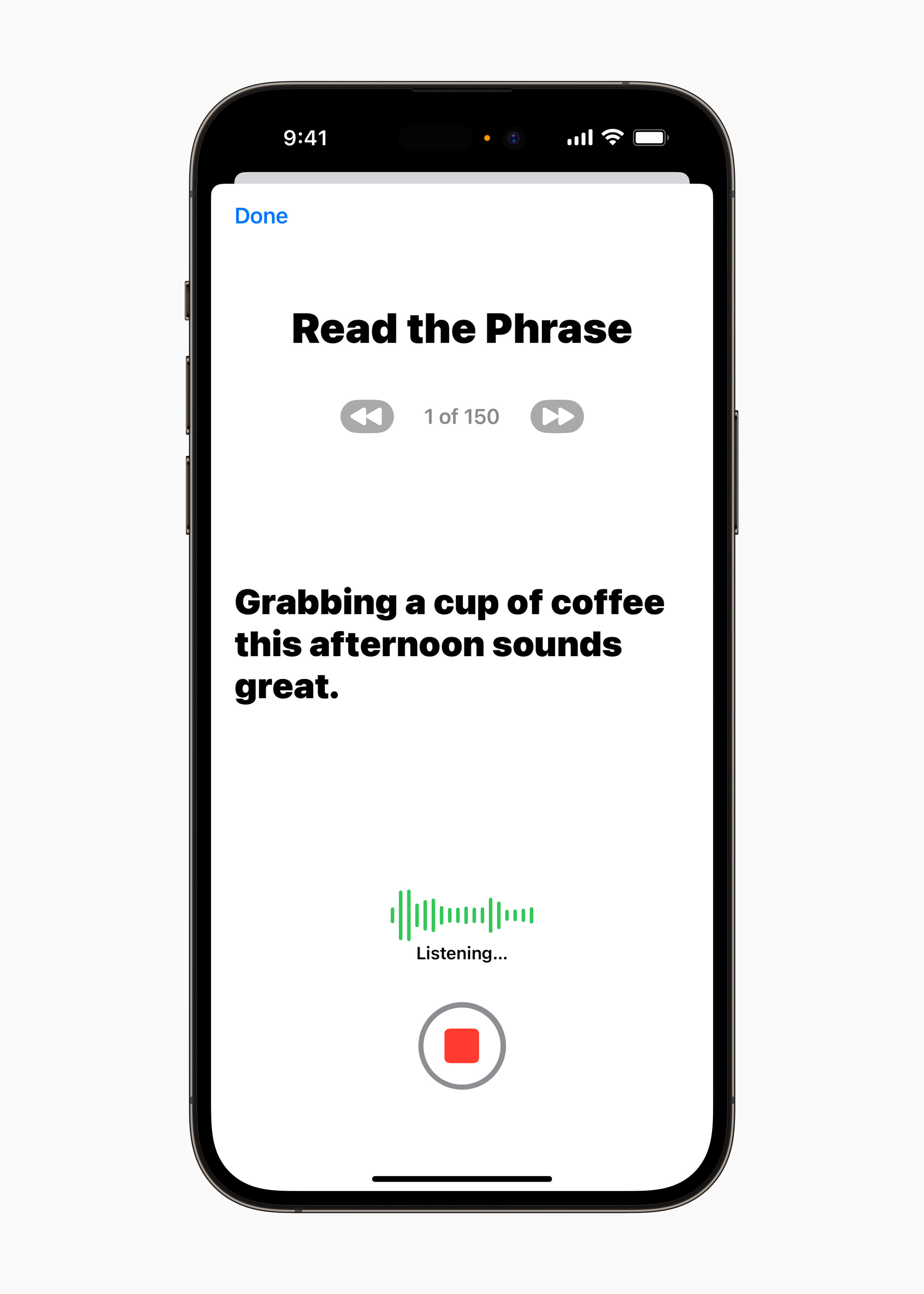

Voix personnelle

Dans la continuité de l'innovation précédente, il existe également une fonction associée à la voix et à la parole, qui, il faut le dire, n'a pas encore d'équivalent. Avec la fonction Personal Voice, les iPhones pourront créer une copie exacte de votre propre voix, que vous pourrez utiliser dans le cas du point précédent. Le texte ne sera pas lu par une voix unifiée, mais par la vôtre. À l'exception des appels téléphoniques, cela peut bien sûr également être utilisé dans les messages audio iMessage, etc. La création complète de votre voix ne prendra pas plus de 15 minutes par l'IA et l'apprentissage automatique, pendant lesquelles vous lirez le texte présenté et d'autres textes. instructions. Ensuite, si pour une raison quelconque vous perdez votre voix, elle sera enregistrée sur votre iPhone et vous pourrez toujours lui parler. Cela ne devrait pas constituer un risque pour la sécurité, car tout se passe localement.

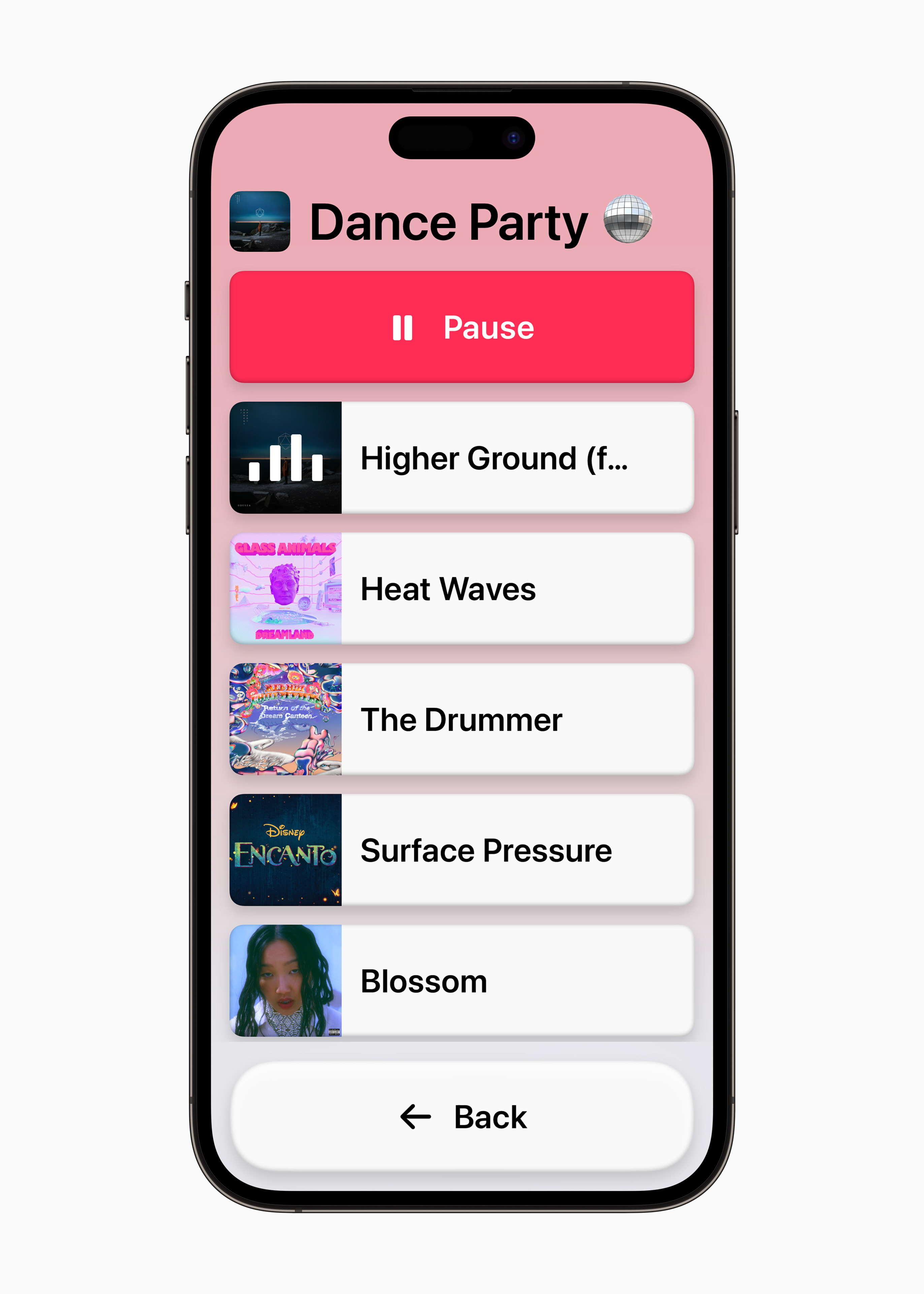

Démarche d'assistance

Dans le monde des appareils Android, le mode senior est une chose assez courante. De plus, il est également très simple à utiliser, tout comme celui qui ajuste l'interface pour les plus petits. Dans le cas des iPhones, le premier mentionné fait l'objet de spéculations depuis longtemps, mais Apple l'a enfin révélé. En l'activant, l'environnement sera globalement simplifié, lorsque, par exemple, des applications telles que Phone et FaceTime seront unifiées, les icônes seront plus grandes et il y aura également des personnalisations, grâce auxquelles l'interface sera configurée exactement selon les besoins de l'utilisateur (vous pouvez mettre une liste à la place d'une grille, etc.).

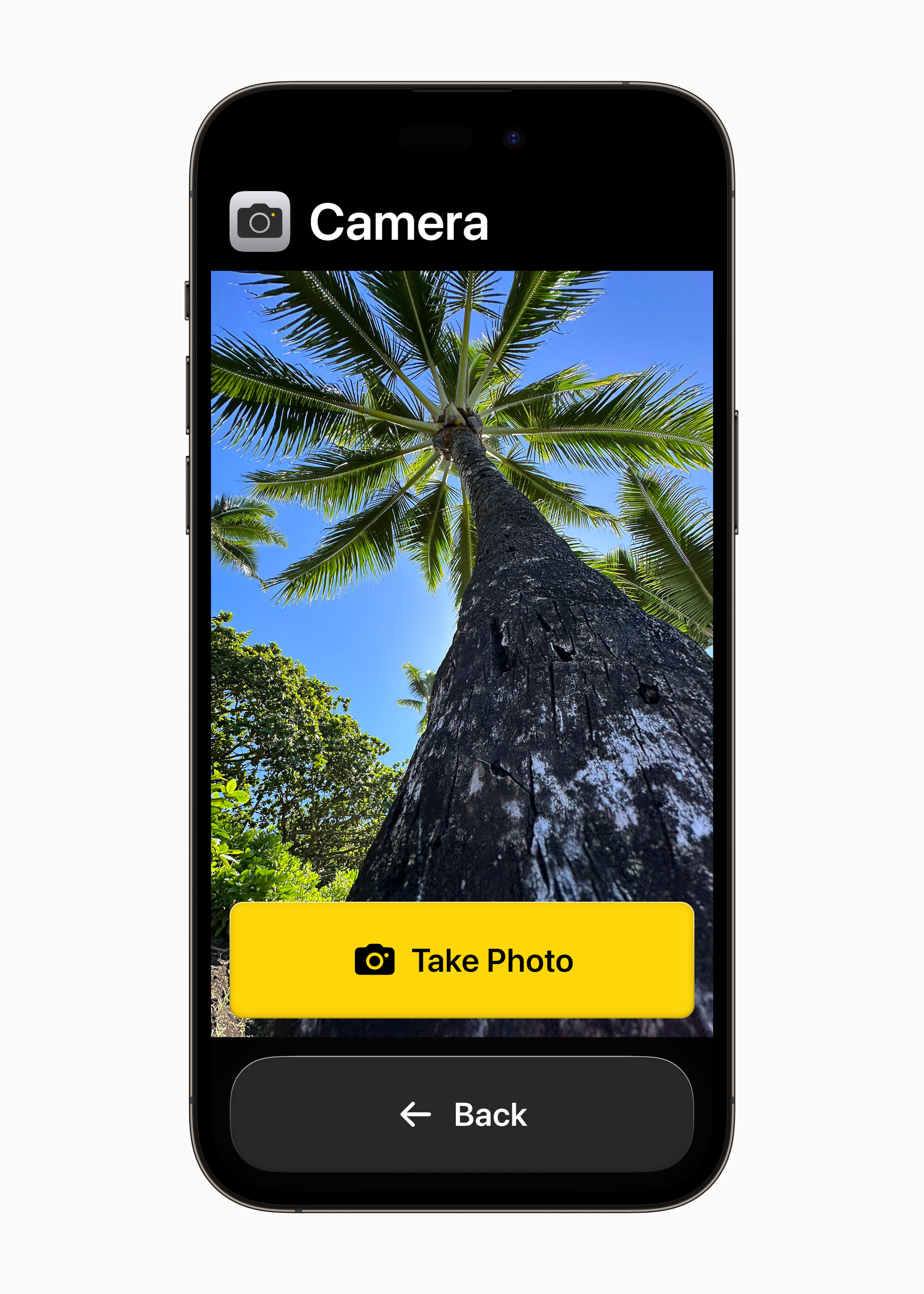

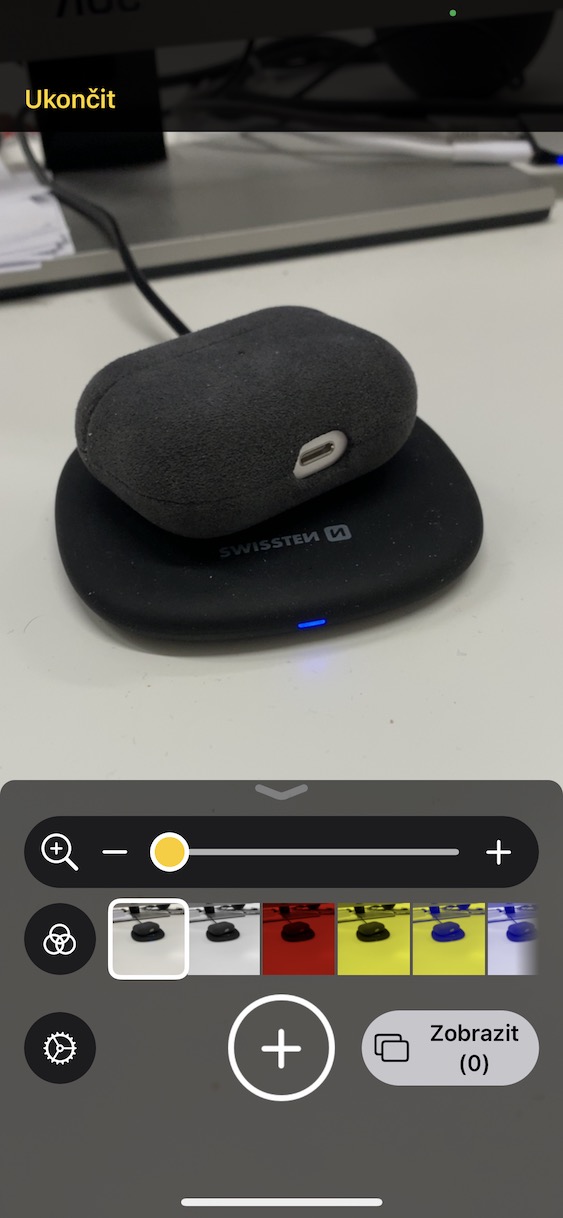

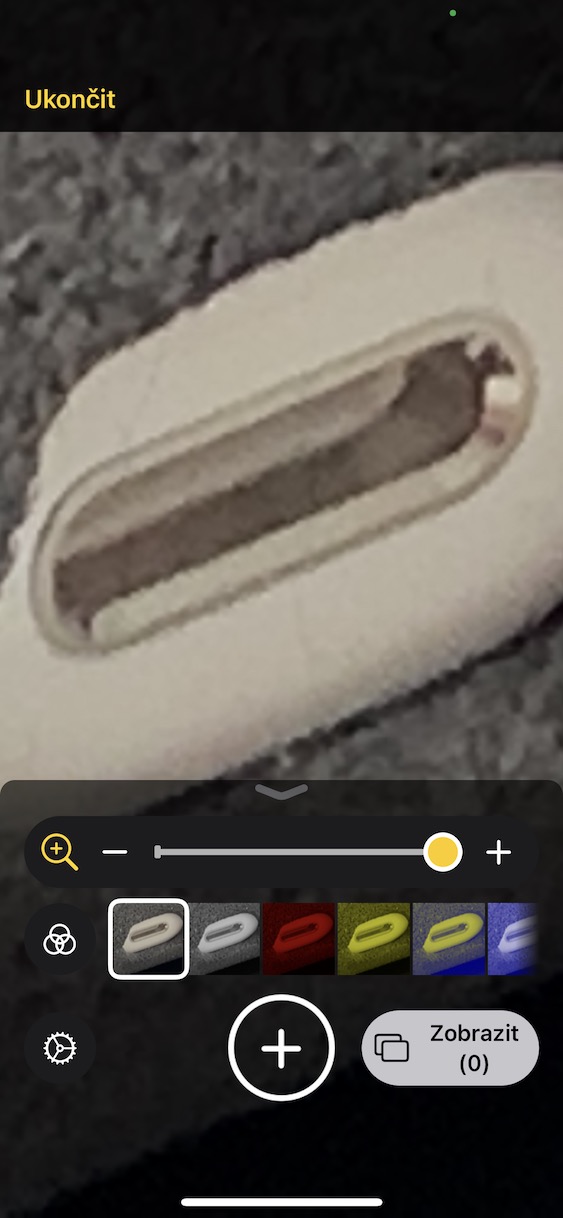

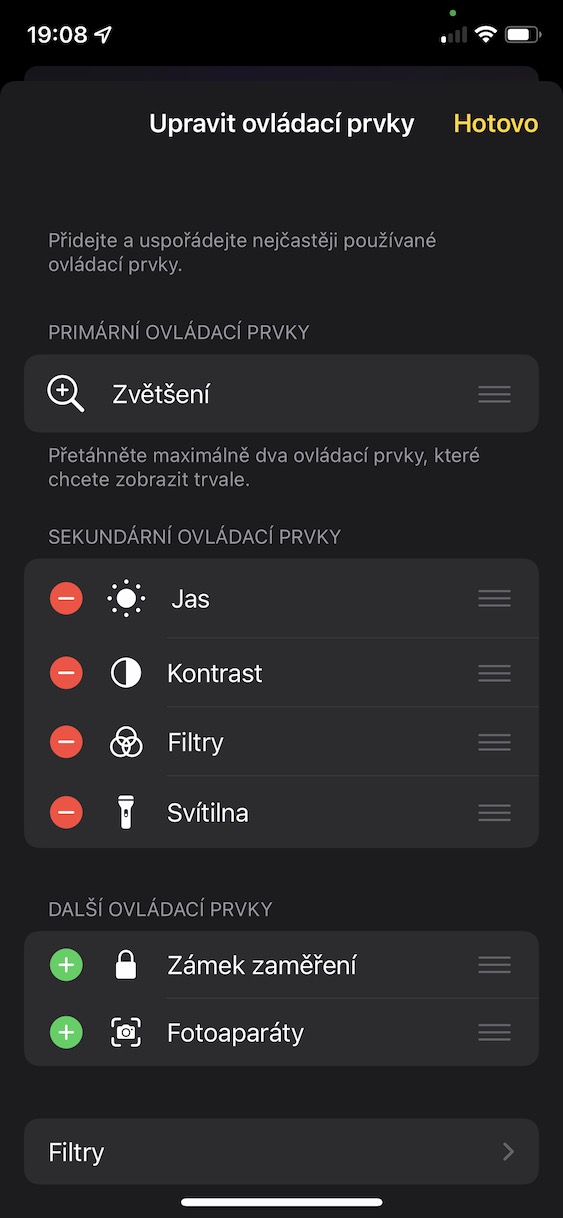

Mode de détection des fonctionnalités de la loupe

Si quelqu'un souffre d'une déficience visuelle, Apple essaiera de lui faciliter la vie en utilisant la fonction Loupe, qui utilise l'apprentissage automatique et l'IA pour essayer de reconnaître ce que l'utilisateur du téléphone pointe via le viseur de l'appareil photo. La fonction doit alors le reconnaître correctement et l'informer vocalement. Après tout, il existe de nombreuses applications sur ce sujet dans l'App Store, elles sont très populaires et très fonctionnelles, il est donc clair d'où Apple s'est inspiré. Mais Apple va encore plus loin dans le cas du pointage direct, c'est-à-dire oui, avec le doigt. Ceci est utile, par exemple, avec différents boutons sur les appareils, lorsque l'utilisateur saura clairement quel doigt il a et s'il doit appuyer dessus. Néanmoins, la loupe devrait également être capable de reconnaître des personnes, des animaux et bien d'autres choses, ce qui, après tout, peut également être fait par Google Lens.

Plus d'actualités Accessibilité

Une autre ligne de fonctions a été publiée, parmi lesquelles deux méritent d'être signalées en particulier. Le premier est la possibilité de mettre en pause les images contenant des éléments en mouvement, généralement des GIF, dans Messages et Safari. Après cela, il s'agit de la vitesse de parole de Siri, que vous pourrez limiter de 0,8 jusqu'à doubler la vitesse.

Il pourrait être vous intéresse

Adam Kos

Adam Kos