Le système d'exploitation mobile iOS 13 apporte également une fonction très intéressante qui permet aux applications de capturer différents clichés de différentes caméras d'un même appareil, y compris le son.

Quelque chose de similaire fonctionne sur Mac depuis l'époque du système d'exploitation OS X Lion. Mais jusqu’à présent, les performances limitées du matériel mobile ne le permettaient pas. Cependant, avec la dernière génération d'iPhone et d'iPad, même cet obstacle tombe, et iOS 13 peut donc enregistrer simultanément à partir de plusieurs caméras sur un seul appareil.

Il pourrait être vous intéresse

Grâce à la nouvelle API, les développeurs pourront choisir à partir de quelle caméra l'application prend quelle entrée. En d’autres termes, par exemple, la caméra avant peut enregistrer des vidéos tandis que la caméra arrière prend des photos. Cela s'applique également au son.

Une partie de la présentation à la WWDC 2019 consistait en une démonstration de la manière dont une application peut utiliser plusieurs enregistrements. L'application pourra ainsi enregistrer l'utilisateur et en même temps enregistrer l'arrière-plan de la scène avec la caméra arrière.

Enregistrement simultané de plusieurs caméras uniquement sur les nouveaux appareils

Dans l'application Photos, il était alors possible d'échanger simplement les deux enregistrements pendant la lecture. De plus, les développeurs auront accès aux caméras TrueDepth avant sur les nouveaux iPhones ou à l'objectif grand angle ou téléobjectif à l'arrière.

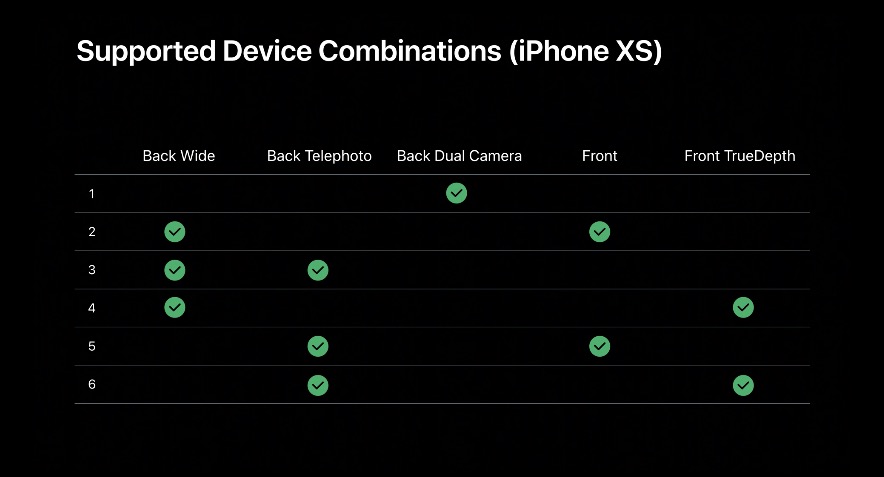

Cela nous amène à la limitation qu’aura la fonction. Actuellement, seuls les iPhone XS, XS Max, XR et le nouvel iPad Pro sont pris en charge. Aucun autre appareil neuf fonctionnalité dans iOS 13 ils ne peuvent pas encore l'utiliser et ne le pourront probablement pas non plus.

De plus, Apple a publié des listes de combinaisons prises en charge. Après un examen plus approfondi, nous pouvons conclure que certaines restrictions ne sont pas tant de nature matérielle que logicielle, et Cupertino bloque délibérément l'accès à certains endroits.

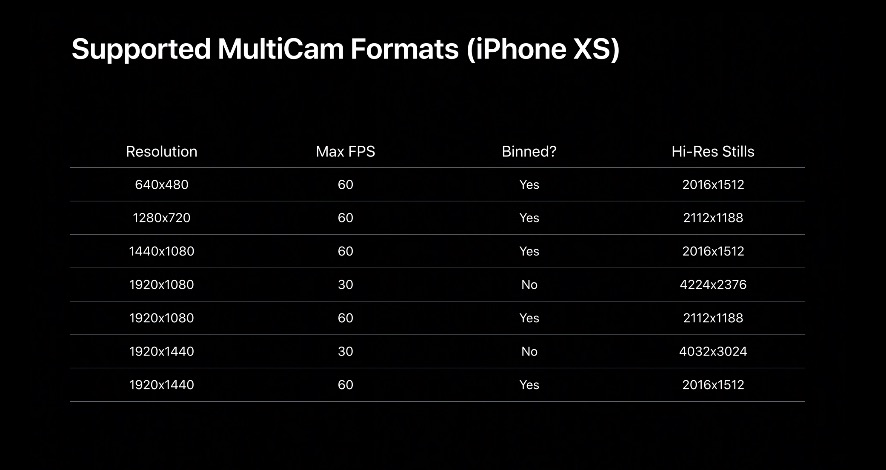

En raison de la capacité de la batterie, les iPhones et iPads ne pourront utiliser qu’un seul canal de séquences multi-caméras. Au contraire, Mac n’a pas de telle limitation, pas même les MacBook portables. De plus, la fonctionnalité présentée ne fera probablement même pas partie de l’application Appareil photo du système.

Le fantasme d'un développeur

Le rôle principal sera donc celui des compétences des développeurs et de leur imagination. Apple a montré encore une chose, à savoir la reconnaissance sémantique des segments d'image. Rien d'autre n'est caché sous ce terme que la capacité de reconnaître un personnage dans une image, sa peau, ses cheveux, ses dents et ses yeux. Grâce à ces zones détectées automatiquement, les développeurs peuvent alors attribuer différentes parties du code, et donc des fonctions.

Il pourrait être vous intéresse

Lors de l'atelier WWDC 2019, une application a été présentée qui filmait l'arrière-plan (cirque, caméra arrière) en parallèle avec le mouvement du personnage (utilisateur, caméra frontale) et était capable de définir la couleur de la peau du clown à l'aide de régions sémantiques. .

Nous ne pouvons donc qu’attendre avec impatience la manière dont les développeurs adopteront la nouvelle fonctionnalité.

Source: 9to5Mac