Avec l'arrivée d'hier iOS 13.2 bêta La fonctionnalité Deep Fusion attendue est arrivée sur les iPhone 11 et 11 Pro (Max), qui est un système de traitement d'image avancé lors de la prise de photos avec les nouveaux iPhones. Grâce à Deep Fusion, les photos prises sous un éclairage moyen sont de qualité nettement meilleure, et surtout, elles sont nettement plus riches en détails divers. Bien qu’il puisse sembler à beaucoup qu’une fonction logicielle à elle seule ne peut pas améliorer de manière significative les images, c’est le contraire qui est vrai. Le tout premier test Deep Fusion montre probablement clairement que les iPhones 11 prendront des photos encore meilleures après la mise à jour vers iOS 13.2.

Il pourrait être vous intéresse

D'une certaine manière, Deep Fusion peut être comparé à mode nuit, que possèdent également les nouveaux iPhones. Mais alors que le mode Nuit est activé dans des conditions de lumière très faible, c'est-à-dire surtout la nuit, Deep Fusion a pour tâche d'améliorer les photos dans une lumière moyenne, c'est-à-dire dans l'obscurité ou à l'intérieur des bâtiments. Il est également important de savoir que Deep Fusion s'active de manière entièrement automatique en arrière-plan, et que le mode ne peut être activé/désactivé nulle part dans les paramètres ou directement dans l'application Appareil photo.

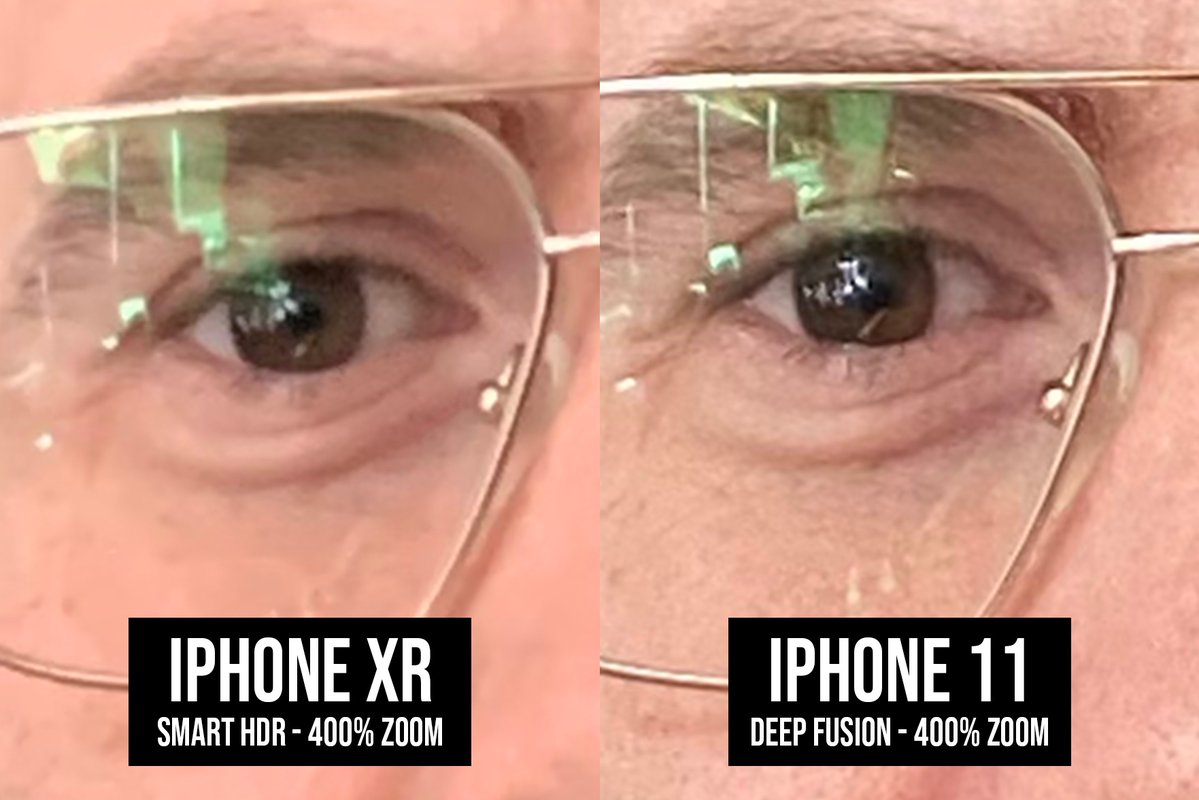

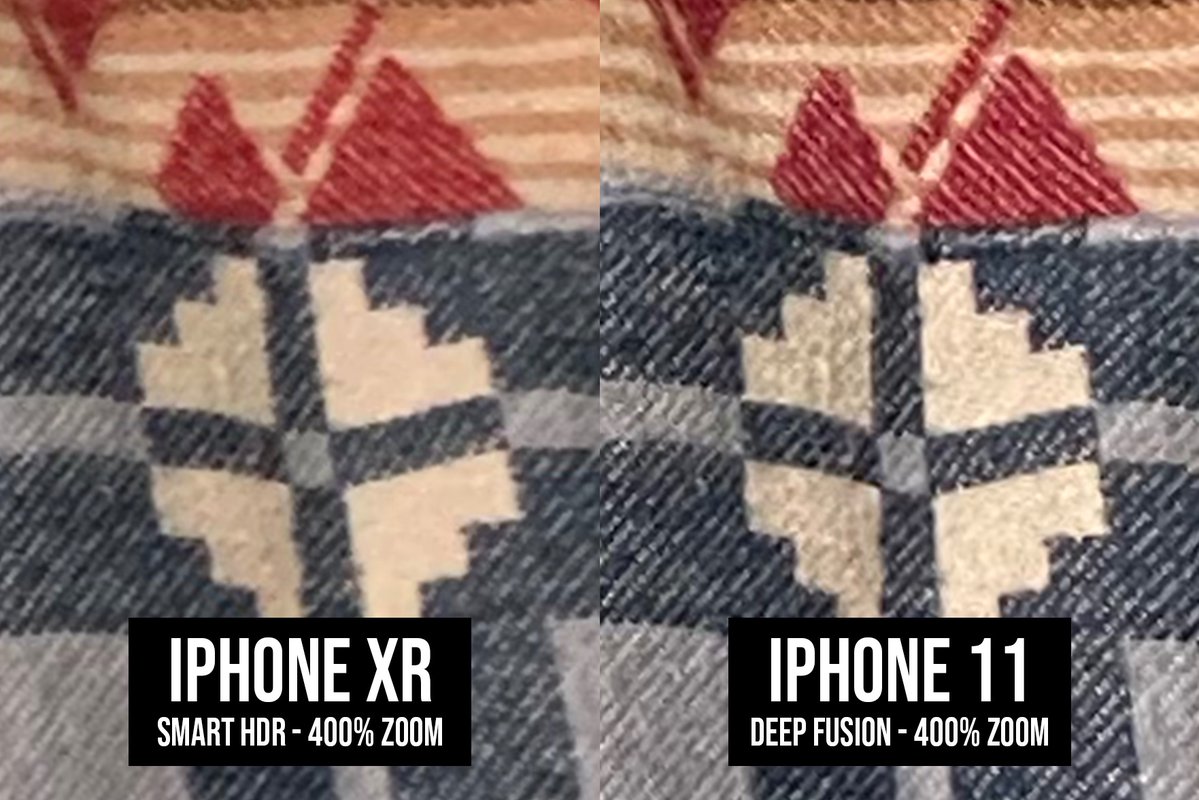

Bien que la fonctionnalité soit actuellement en phase de test et fasse partie de la version bêta d'iOS 13.2, elle montre déjà des résultats vraiment intéressants. Premier test photo publié Tyler Stalman sur Twitter montre comment, grâce à Deep Fusion, le rendu des détails individuels s'est sensiblement amélioré. En raison du fait que la fonction ne peut en aucun cas être activée ou désactivée, Stalman a comparé les photos prises par l'iPhone XR avec la fonction Smart HDR et l'iPhone 11 avec Deep Fusion. Cependant, il a également ajouté des images de deux iPhone 11 Pro différents, le premier utilisant Smart HDR (iOS 13.1) et le second avec Deep Fusion (iOS 13.2). Vous pouvez voir le résultat dans la galerie ci-dessous.

Deep Fusion utilise les capacités de la puissante puce A13 Bionic et de son nouveau Neural Engine, lorsque la photo capturée est ensuite traitée pixel par pixel à l'aide de l'apprentissage automatique, optimisant ainsi les textures, les détails et le bruit éventuel dans chaque partie de l'image. Avant d'appuyer sur le déclencheur, trois photos sont prises en arrière-plan avec un temps d'exposition court. Par la suite, en appuyant sur le déclencheur, le téléphone prend trois autres photos classiques puis une supplémentaire avec une pose longue avec tous les détails. Un algorithme créé par Apple combine ensuite les images de manière sophistiquée et tous les détails sont mis en valeur. Le résultat est une image de très haute qualité. Nous avons écrit il y a quelques jours comment fonctionne exactement Deep Fusion, étape par étape dans cet article.

Je ne veux marcher sur les cors de personne, mais avec tout ce qui est attendu pour cette fonctionnalité et combien Apple rend la tâche difficile... vous ne pouvez pas voir la différence au premier coup d'œil. Il semble plutôt qu'ils aient désactivé le lissage du visage et réglé la netteté à 110 %.