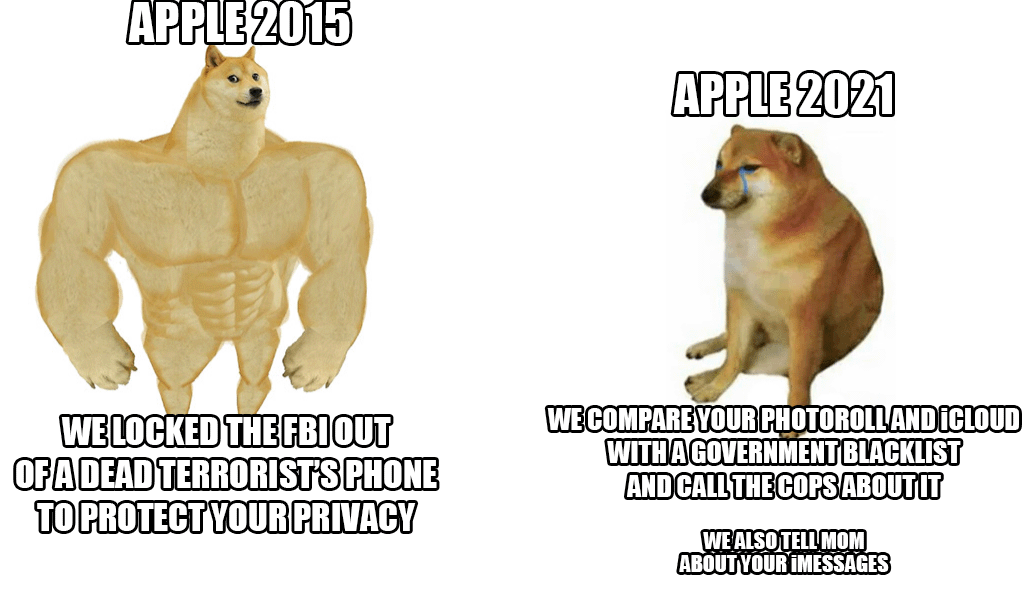

À la fin de la semaine dernière, Apple a dévoilé un nouveau système anti-maltraitance envers les enfants qui analysera les photos iCloud de pratiquement tout le monde. Bien que l'idée semble bonne à première vue, car les enfants ont vraiment besoin d'être protégés de cette action, le géant de Cupertino a néanmoins été critiqué par une avalanche - non seulement de la part des utilisateurs et des experts en sécurité, mais aussi des rangs des employés eux-mêmes.

Selon les dernières informations d'une agence respectée Reuters un certain nombre de collaborateurs ont exprimé leurs inquiétudes concernant ce système dans une communication interne sur Slack. Apparemment, ils devraient craindre d'éventuels abus de la part des autorités et des gouvernements, qui pourraient abuser de ces possibilités, par exemple pour censurer des personnes ou des groupes sélectionnés. La révélation du système a déclenché un vif débat, qui compte déjà plus de 800 messages individuels au sein de Slack susmentionné. Bref, les salariés sont inquiets. Même les experts en sécurité ont déjà attiré l'attention sur le fait que, entre de mauvaises mains, ce serait une arme très dangereuse utilisée pour réprimer les militants, leur censure, etc.

La bonne nouvelle (pour l’instant) est que la nouveauté ne démarrera qu’aux États-Unis. Pour l’instant, il n’est même pas clair si le système sera également utilisé dans les États de l’Union européenne. Cependant, malgré toutes les critiques, Apple se démarque et défend le système. Il fait valoir avant tout que toutes les vérifications ont lieu à l'intérieur de l'appareil et qu'une fois qu'il y a une correspondance, ce n'est qu'à ce moment-là que le cas est à nouveau vérifié par un employé d'Apple. Ce n'est qu'à sa discrétion qu'il sera remis aux autorités compétentes.

Il pourrait être vous intéresse

Je détesterais passer d'iCloud à quelque chose de sécurisé et de véritablement privé, mais si Apple insiste, j'arrêterai de toute façon de les payer.

Il ne sera actif (pour l'instant) qu'aux États-Unis

Peu importe où cela s’appliquera sur le plan législatif. Cette technologie sera déjà disponible et déployée. C'est le plus gros risque.